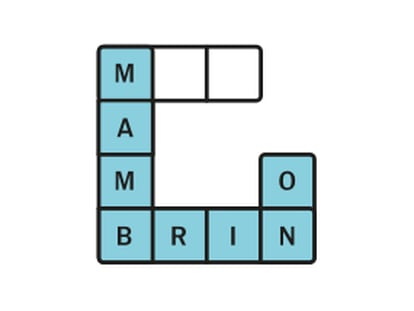

Moderación viene de “modo”

La libertad de expresión tiene que ver con “qué” se dice y la cortesía, con “cómo”

Google acaba de presentar su herramienta Perspective, que utiliza inteligencia artificial para luchar contra los trolls e identificar comentarios tóxicos en las webs, para que puedan ser revisados y, en su caso, excluidos de la conversación.

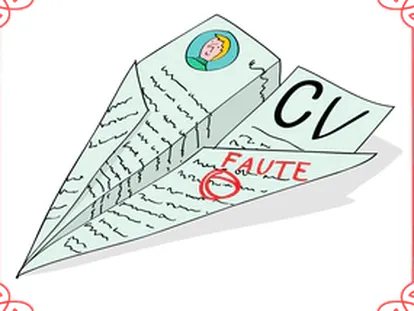

Lo que en principio parece una noticia positiva “para crear una buena conversación en Internet”, tiene el riesgo de acabar siendo una herramienta de la peor censura de todas, que es la de lo políticamente correcto; o, todavía peor, la auto-censura.

La clave está en saber qué criterios se utilizan por esta herramienta para considerar un comentario como tóxico y si se pueden borrar contenidos que no son ilegales, limitando, así, el derecho humano universal a la libertad de expresión.

Machine learning / Human teaching

Perspective se basa en el aprendizaje automático (machine learning), en el que el papel del ser humano es fundamental, porque un equipo de personas se dedica a revisar comentarios y crear una base de datos en la que se incluyen aquellos que se consideran “tóxicos” (insultos, palabrotas o faltas de respeto), que luego utiliza la máquina para revisar y marcar los comentarios que coinciden con ellos.

Por eso, allí donde hay un aprendizaje (learning) existe un magisterio (teaching) y lo más importante del machine learning no es la tecnología o los algoritmos, sino el human teaching; es decir, los criterios que utilizan los humanos para enseñar o entrenar a la Inteligencia Artificial a pensar (como ellos). Y, por eso, una misma herramienta puede ofrecer distintos resultados según quién la entrene.

Otra posibilidad es que el sistema se entrene por los propios usuarios de las webs, que pueden denunciar (o no) aquellos comentarios que consideren “tóxicos”. Pero ya se ha visto, por alguna experiencia de chatbot (robot de conversación en redes sociales), como la que tuvo Microsoft, que la Inteligencia Artificial puede juntarse con malas compañías y aprender a decir (o a censurar) algo que no debe.

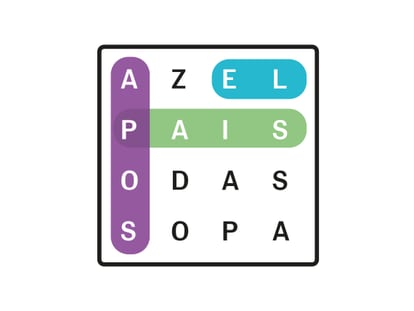

La cortesía o netiqueta

¿Cómo conciliar la libertad de expresión y un buen ambiente para la conversación? Quizá recuperando valores tan antiguos como la netiqueta de los primeros años de internet, que no es sino la buena educación o la cortesía.

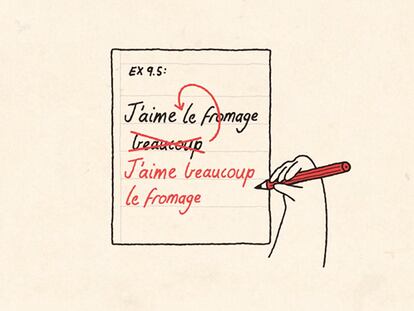

La libertad de expresión tiene que ver con qué se dice y la cortesía, con cómo. Se debe poder hablar de todo e, incluso, expresar opiniones que puedan molestar, pero uno debe siempre cuidar las formas en que se expresa.

Ese es el sentido de la moderación de los comentarios. Como hace el Presidente del Congreso de los Diputados cuando llama a un diputado al orden y a guardar la debida cortesía parlamentaria. Moderación viene de modo.

Twitter y su filtro de calidad

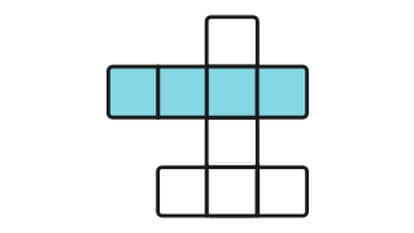

Hace unos meses Twitter presentó su propia estrategia para controlar a los trolls (provocadores) y haters (personas que publican mensajes de odio) mediante una serie de filtros que permiten al usuario, no eliminar, pero sí ocultar sus comentarios.

Lo que más me llamó la atención es el llamado filtro de calidad (de los tuits), que, según Twitter, “permite mejorar la calidad de los tuits que ves gracias a que utiliza una variedad de señales, como el origen y el comportamiento de la cuenta”.

“Cuando se activa, filtra el contenido de menor calidad, como los tuits duplicados o el contenido que parezca automatizado”, tanto en la cronología de notificaciones como en los principales resultados de búsqueda y en las respuestas.

Eso, unido a las posibilidades de silenciar o bloquear a determinadas personas y de silenciar palabras específicas, permite al usuario no leer cosas previsiblemente ofensivas, pero no las elimina y de hecho otros usuarios las pueden seguir leyendo.

En este caso se ha optado por “ojos que no ven, corazón que no siente”. Pero el daño —si existe— sigue ahí, a la vista de los demás; y, sobre todo, no leerás lo malo, pero te puedes perder también lo bueno, porque, entre el fango, puede haber oro.

Lo mejor de esta vida no está previsto

¿Qué pasaría si en la vida presencial bloqueáramos a determinadas personas o silenciáramos mensajes y conversaciones que contuvieran palabras específicas?, ¿tendríamos una vida de mejor o peor calidad?

Si sólo recibiéramos las interacciones sociales de las personas que ya conocemos, no conoceríamos personas nuevas, ni nuevos puntos de vista. No veríamos cosas previsiblemente malas, pero tampoco cosas buenas imprevisibles.

Nadie sabe de quién se va a enamorar, ni en qué va a trabajar, ni dónde va a vivir. Y muchas veces lo que cambia tu vida lo encuentras en el lugar más insospechado. Por eso prefiero leer y vivir sin filtros, porque lo mejor de esta vida no está previsto.

Borja Adsuara es profesor, abogado, consultor y experto en derecho y estrategia digital.